- Что такое файл robots.txt

- Как работает файл robots.txt

- Два типа роботов: вы -агенты и роботы

- Команда Disallow

- Что касается изображений, они устраняются следующим образом:

Наша команда-партнер Artmisto

Время чтения: 5 минут

Редкий день, когда мы не используем Google для поиска какой-либо информации. Самая известная поисковая система в мире предлагает нам всевозможные решения для нашей жизни, поскольку она является одной из проще использовать бренды для граждан. Однако поисковым системам нужна информация, они любопытны по своей природе и хотят знать абсолютно все о нашей жизни и веб-страницах . Короче говоря, они жаждут знаний и информации, поэтому важно знать об использовании и функционировании файла robots.txt.

У поисковых систем есть машины или роботы, которые отслеживают сеть, чтобы классифицировать и индексировать как можно больше информации в своих базах данных. Robots.txt - это машина, широко используемая в Интернете для индексирования веб-контента. Спаммеры, например, используют их для отслеживания электронных адресов. Но будьте осторожны, у них также есть много других применений, таких как поиск сайтов в XML или блокировка доступа к файлам кода и каталогам

Мир robots.txt захватывающий, и сегодня мы попытаемся немного осветить эту тему, поэтому расскажем, что такое файл robots.txt, что вам нужно знать и как с ними обращаться.

Что такое файл robots.txt

Когда мы создаем новый веб-сайт, нам нужен Google, чтобы иметь возможность доступа к нашей странице для получения нашей информации . Для выполнения этой задачи необходимо создать текстовый файл (с расширением .txt) в нашем домене, чтобы предоставить поисковой системе всю информацию, которую нам интересно знать о нашем веб-сайте или бизнесе. В то же время этот файл .txt используется для предотвращения добавления ботами или robots.txt данных и информации, которыми мы не хотим делиться с компанией Moutain View. По словам Google определение file.txt следующее:

"Файл robots.txt - это файл, который находится в корне сайта и указывает, к каким частям вы не хотите, чтобы поисковые роботы обращались к ним. Файл использует Стандарт исключения роботов , который представляет собой протокол с небольшим набором команд, который может использоваться для указания доступа к веб-сайту по разделам и определенным типам поисковых роботов (таких как мобильные сканеры или компьютерные трекеры). "

Как работает файл robots.txt

Работа robots.txt проще, чем кажется. Прежде всего нам нужно знать, для чего нужен файл robots.txt и какие элементы нашего веб-сайта он может индексировать или нет.

Кроме того, работа robots.txt ограничена, и есть другие системы для наших веб-адресов, которые можно найти в Интернете.

Карта сайта операции robots.txt и его файла на веб-странице.

Имейте в виду, что инструкции robots.txt являются лишь указаниями, а не чем-то определенным. Например, роботы Google под названием Googlebot подчиняются командам в файле robots.txt , но другие поисковые системы ( Яндекс , Alltheweb, ASK или Altavista) не обязаны это делать.

Например, Google не будет сканировать или индексировать какую-либо информацию о содержимом страниц, которые мы блокируем с помощью robots.txt, однако он будет индексировать все адреса или URL-адреса, которые находятся в других элементах или веб-страницах, даже если они ограничены поэтому file.txt, важный совет: если ваша веб-страница будет содержать конфиденциальную информацию, но вы не хотите делиться ею, лучше всего не создавать ее.

Два типа роботов: вы -агенты и роботы

Google различает несколько видов роботов:

- Пользовательские агенты, которые вы используете специально для поиска и предоставления инструкций. Чтобы использовать этого робота, вы должны добавить следующую команду: User-agent: *

- Остальные роботы - это роботы Google: Googlebot-Mobile (специально для мобильных устройств) и Googlebot-Image для изображений и фотографий.

Команда Disallow

Если мы хотим ограничить индексирование файлов для роботов этого типа, мы должны использовать команду «Запретить». Например, если мы хотим удалить некоторый контент с нашего сайта, мы добавим следующее:

- В случае блокировки всего сайта мы добавим косую черту, например: Disallow: /

- Если мы хотим заблокировать каталог и все внутри, мы добавим следующее: Disallow: /https://marketing4ecommerce.net/marketing/

- Чтобы заблокировать целую страницу, она ставится после Disallow следующим образом: Disallow: /https://marketing4ecommerce.net/marketing/

Что касается изображений, они устраняются следующим образом:

- Если вы хотите удалить только изображение: User-agent: Googlebot-Image

Disallow: / images / маркетинг и электронная коммерция.jpg - Если вы хотите удалить все изображения из Google Images , включите следующие команды:

- Пользователь-агент: Googlebot-Image

Disallow: /

- Пользователь-агент: Googlebot-Image

- Чтобы заблокировать файлы определенного типа (например, .gif), вы можете включить следующую команду:

- Пользователь-агент: Googlebot

Disallow: /.gif$

- Пользователь-агент: Googlebot

Другие команды, которые также используются довольно

- Карта сайта - укажите, где находится карта сайта в формате XML.

- Разрешить - работает иначе, чем команда Disallow, так как разрешает доступ к каталогам и страницам. Он также может использоваться частично или полностью для перезаписи команды Disallow.

- Crawl-delay - эта команда сообщает роботу о количестве секунд загрузки между каждой страницей. На самом деле, его использование в предметах SEO повысить скорость загрузки сервера.

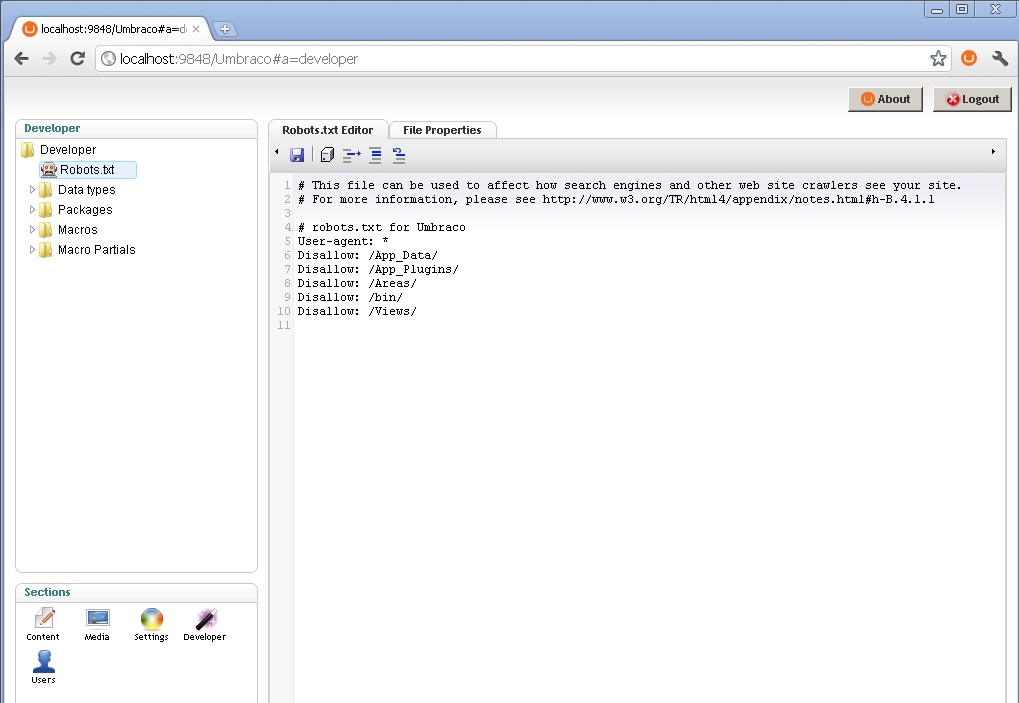

Как создается файл robots.txt

Прежде чем мы прокомментировали, что работа с файлом robots.txt очень проста. Например, для его создания необходимо предоставить доступ к корню домена и загрузить файл в текстовом формате (txt) с именем «robots.txt» в корневой каталог первого уровня нашего сервера, где расположена веб-страница, которую мы хотим проиндексировать. ,

Не забудьте использовать текстовый файл для создания файла , в Windows и Mac есть простые текстовые файлы, которые могут помочь нам. Примером может быть следующее: http: //marketing4ecommerce/robots.txt

Наконец, вы должны проверить работу вашего robots.txt, для этого Google предоставляет нам инструмент тестирования в консоли поиска Google. Там вы можете проверить, как робот Google будет читать файл и сообщать вам о возможных ошибках.

Если вам нужна дополнительная информация по этому вопросу, я рекомендую вам перейти к Страница поддержки Google где они информируют вас обо всем, что вам нужно знать о работе robots.txt. Что вы думаете об ограничении информации с вашего сайта для Google? Вы действительно думаете, что это эффективная система ? Оставьте свое мнение в комментариях и мы с радостью ответим вам.

Будьте в курсе самых актуальных новостей на нашем канале телеграмма

Что вы думаете об ограничении информации с вашего сайта для Google?