Наша команда-партнер Artmisto

Додано 15.04.2016

Web Scraping - це популярний метод отримання контенту практично задарма. У нас такий метод називається «парсинг контенту» або «парсинг сайтів». Метод полягає в тому, що спеціально навчений алгоритм заходить на головну сторінку сайту і починає переходити по всіх внутрішніх посиланнях, ретельно збираючи нутрощі зазначених вами div-ів. Як результат роботи - готовий CSV файл, в якому вся потрібна інформація лежить в строгому порядку.

Навіщо?

Отриманий CSV можна використовувати для подальшої генерації майже унікального контенту. Та й в цілому, як таблиця, такі дані представляють велику цінність. Уявіть, що весь асортимент якогось будівельного магазину представлений в таблиці, до того ж для кожного виробу, для кожного підвиду і марки вироби заповнені всі поля та характеристики. Якщо наповненням інтернет-магазину займається копірайтер, то він буде щасливий мати такий CSV файл, і ви можете побачити на його очах сльози вдячності. Якщо створенням контенту займається бездушний алгоритм і душевним ім'ям «Ніна», то тексти придбають осмисленість, користь і, звичайно ж, силу землі.

Які кнопки тиснути?

Інструментів, насправді, море, і спробувати все немає ні можливості, ні бажання. В нашій команді ми благополучно користуємося ScrapingHub. Давайте-но подивимося, як саме ми це робимо.

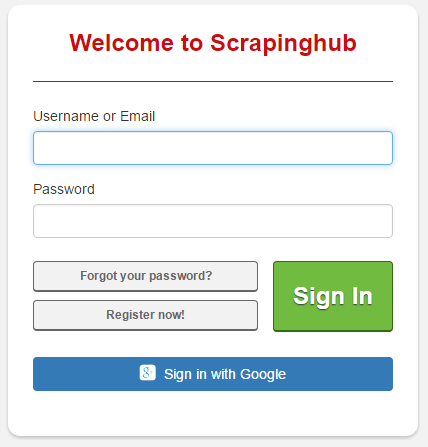

Спочатку логіном або реєструємося:

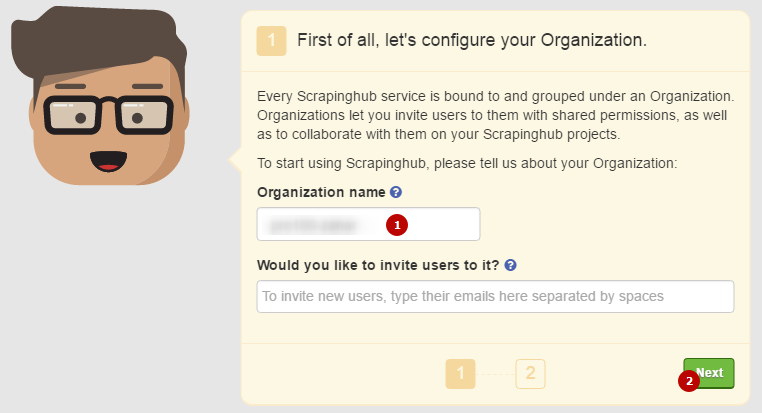

Після цього з'являється безглуздість аватар, який просить вас ввести якісь дані. Забиваємо на цю справу і судорожно тиснемо Next:

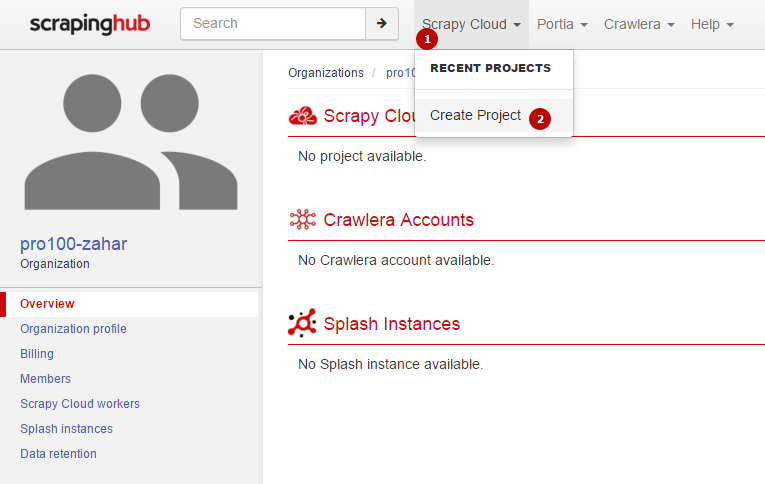

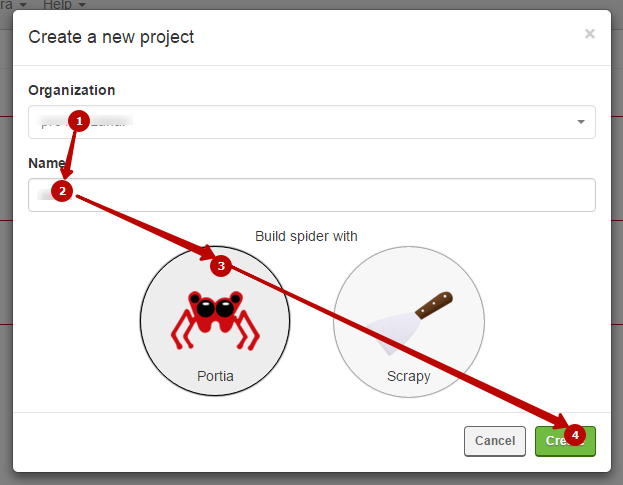

Потім ви потрапляєте в особистий кабінет. Тут вам необхідно створити новий проект - ось так:

Тут вам потрібно вибрати алгоритм (будемо розглядати алгоритм Portia), а також дати ім'я проекту. Назвемо його як-небудь незвично. Наприклад, «111».

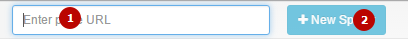

Все, потрапляємо в робочий простір алгоритму, де вже потрібно вводити сайт, який ми будемо аналізувати довільні. Натискаємо «New Spider».

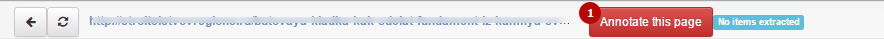

Потім переходимо на сторінку, яка буде прикладом. У хедері оновиться адресу. Тиснемо Annotate This Page.

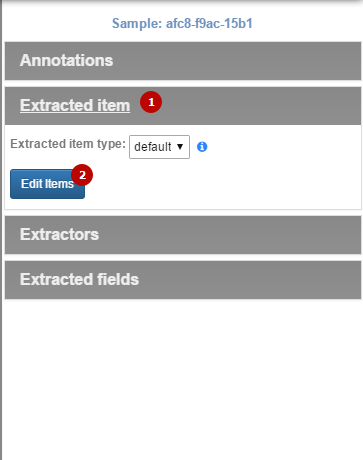

Ведемо курсор миші вправо, після чого з'являється меню. Тут нас цікавить вкладка «Extracted item», де потрібно натиснути «Edit Items».

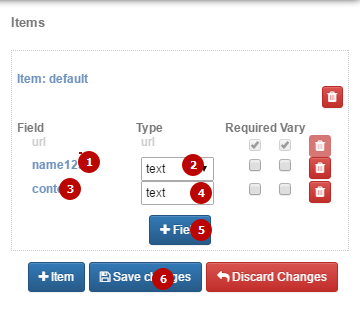

Відображається поки порожній список наших полів. Тиснемо «+ Field».

Тут все просто: необхідно створити список полів. Для кожного item потрібно ввести ім'я (в нашому випадку, це заголовок і контент », вказати, чи є це поле обов'язковим (« Required ») і чи може воно змінюватися (« Vary »). Якщо ви вказуєте, що якийсь Item є обов'язковим, то парсер буде просто пропускати сторінки, де не зможе заповнити це поле. Якщо галочку не ставити, то парсинг може тривати нескінченно довго. Тиснемо Save Changes.

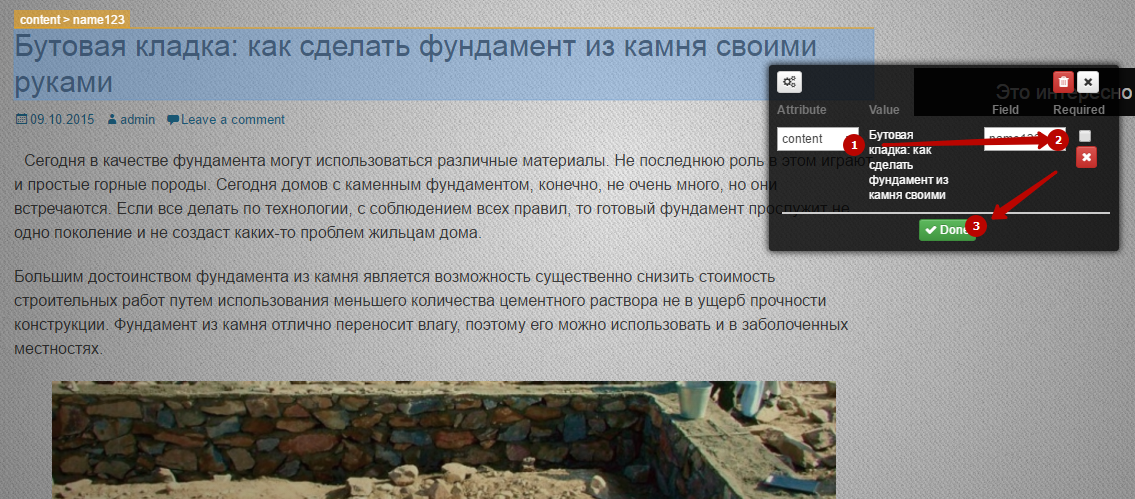

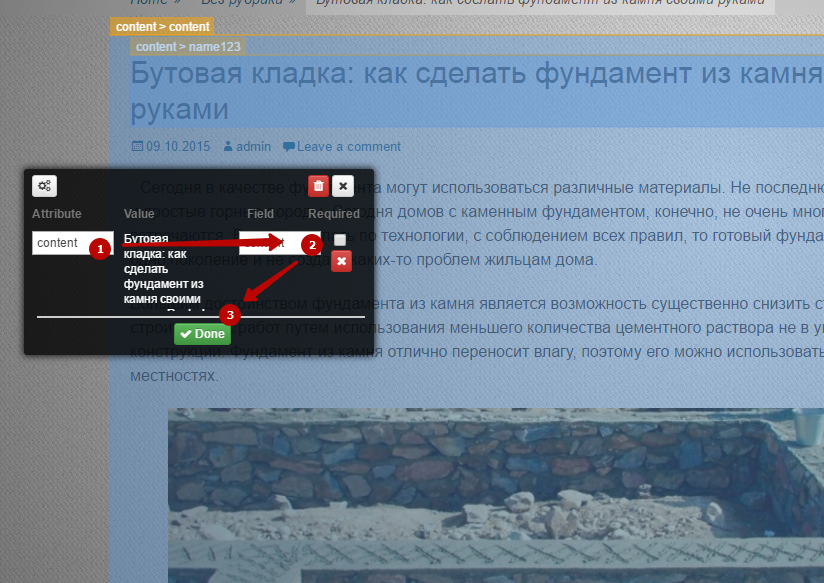

Тепер тупо мишкою клацаємо по потрібному нам полю і вказуємо, що це таке:

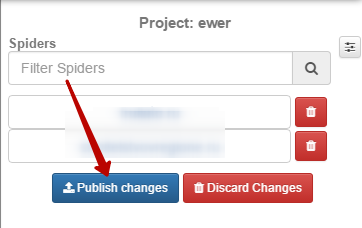

Все вказали? Тоді в шапці сайту тиснемо «Save Sample». Після цього можете повертатися в робочий кабінет. Тепер парсер вміє щось діставати, потрібно поставити йому завдання. Для цього натискаємо "Publish Changes".

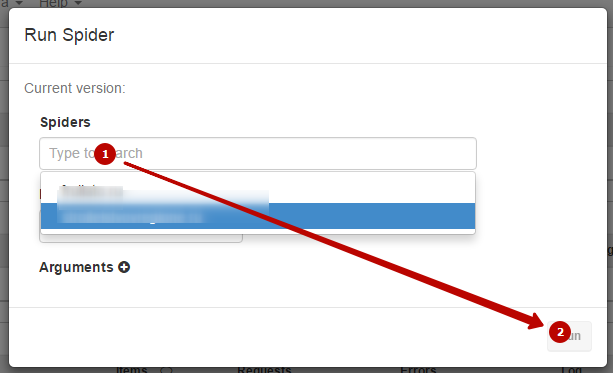

Переходимо до дошки із завданнями. Тиснемо "Run Spider". Вибираємо сайт і пріоритет. Пуск! Ой ... тобто RUN! RUN, FOREST, RUN!

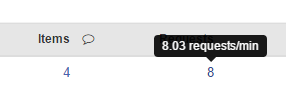

Ну, власне, парсинг пішов. На безкоштовних версіях йде він довго: близько 10-50 запитів в хвилину, в залежності від швидкості сервера, погоди і знака зодіаку, в якому зараз знаходиться Меркурій. Швидкість парсинга показується по наведенню на кількість відправлених запитів:

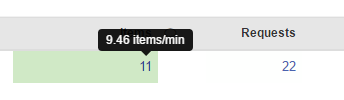

Швидкість отримання готових рядків в CSV - з наведення на інше число.

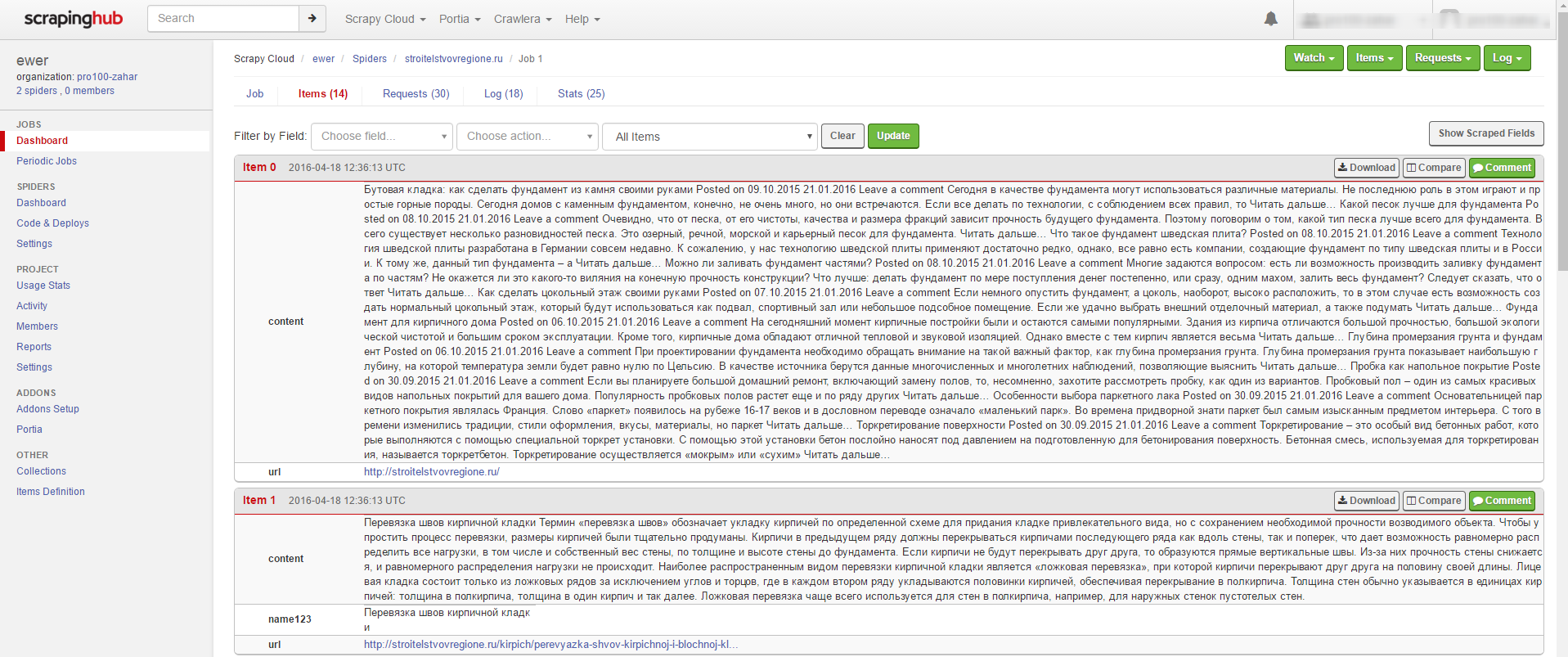

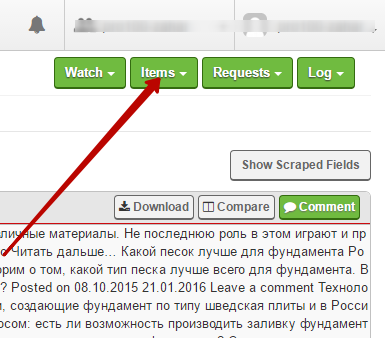

Щоб побачити список вже зроблених Items - просто клацніть по цьому числу. Побачите щось подібне:

Коли парсинг закінчиться, результат можна зберегти ось по цій кнопці:

Як бачите, тут є все, що може знадобитися починаючому фахівцеві в області парсинга.

На цьому лекція закінчена. Домашнього завдання не буде. Перший ряд - ви виняткові. Є питання?

- Вибачте, а як можна від цього захиститися?

- Сайт WinStyle.Ru захищається від цього хитро: кожен раз при оновленні сторінки все їх div-и отримують нові назви (відповідно, змінюються і назви класів в CSS). Цього більш, ніж достатньо для того, щоб парсинг перестав мати сенс.

- Скільки триває парсинг одного сайту?

- А скільки коштує одна таблетка? Дивлячись які розміри має сайт, як довго сервер відповідає на запити. На нашій практиці деякі сайти повністю Парс майже за тиждень. Саме сайт "Будівельні Поради" Парс 44 хвилини 10 секунд, було отримано 1550 записів при 1897 запитах. Такі справи.

- Як реагують пошуковики на подібного роду контент?

- Як використовувати в подальшому отримані дані, вирішувати вам. Готові CSV ви можете використовувати для генерації нових текстів; як уже говорилося вище, такий CSV файл буде дуже корисний як копірайтер, так і алгоритму "Ніна" . Чи можна вставляти такий контент цілком без обробки? Ми не знаємо. Якщо вам вдасться представити цей контент в більш зручному вигляді, ваш сайт буде простіше і комфортніше для користувача, ніж джерело - чом би й ні. Але ми б на це ставку не робили. Парсенн контент - це "сировина", яке ще потрібно переробити.

- Вибачте, але красти контент не хорошо! ..

- Іди, я тебе поцілую, мій золотий.

Навіщо?Які кнопки тиснути?

Навіщо?

Які кнопки тиснути?

Є питання?

Вибачте, а як можна від цього захиститися?

Скільки триває парсинг одного сайту?

А скільки коштує одна таблетка?

Як реагують пошуковики на подібного роду контент?

Чи можна вставляти такий контент цілком без обробки?