- Создание файла

- Основные директивы

- Часто допускает ошибки при создании директив

- Примеры инструментов для тестирования содержимого файла robots.txt.

- суммирование

Наша команда-партнер Artmisto

Адаптация веб-сайта к рекомендациям Google является одной из основных проблем, которую должен учитывать владелец веб-сайта. Совместное использование всего содержимого веб-сайта поисковой системы по своей сути связано с файлом robots.txt и содержащимися в нем директивами о блокировке.

Создание файла

Чтобы создать файл robots.txt, вам необходим доступ к корневому каталогу (обычно public_html) интересующей вас страницы. Альтернативными вариантами являются защита содержимого в виде пароля или использование соответствующих метатегов в разделе заголовка кода страницы.

Основные директивы

Стандартный и в то же время файл robots.txt по умолчанию выглядит следующим образом:

Это означает, что мы предоставляем всем роботам для сканирования и индексирования весь контент на странице.

Директивы в robots.txt:

- Пользователь-агент: [точное имя робота, на которое распространяется директива]

Если вы поставите отметку *, директива Allow / Disallow в файле robots.txt будет применяться ко всем роботам.

- Разрешить: [мы вводим департамент или сектор, директива запретить запрет на которые не применяется]

Применяется для расширения стандартного синтаксиса robots.txt, чтобы разблокировать ресурсы сайта для робота или роботов.

- Disallow: [блокирование определенного содержимого сайта, которое мы установили]

Директива "/" блокирует весь контент сайта для ранее упомянутых индексирующих роботов. Он используется, например, в случае работы с пробной версией, блокируя определенные нежелательные ресурсы на сайте.

Примечание:

- Обратим внимание на размер букв в директивах, которые важны для роботов.

- Googlebots (поисковые роботы Google) не обращают внимания на пробелы, используемые в файле robots.txt, или на инструкции, которые никак не связаны с указанными выше директивами.

Примеры применения директив:

- Для графических файлов с расширением .jpg

Пользователь-агент: Googlebot Disallow: /*.jpg$

Приведенная выше директива блокирует доступ роботов Google ко всем файлам изображений с расширением .jpg.

Пользователь-агент: Googlebot Disallow: / private /

Директива о блокировке содержимого каталога / private / для роботов Google.

- Для определенного адреса каталога

Пользователь-агент: Googlebot Disallow: / private / $

Директива, которая блокирует каталог / private / каталог Google robots. Знак $ означает, что директива должна применяться только к этому адресу, а не ко всему содержимому каталога.

Пользователь-агент: Googlebot Disallow: /private_file.html

Директива, которая блокирует адрес / private_file.html для роботов Google.

Часто допускает ошибки при создании директив

- Согласованность структуры URL - мы должны обратить внимание на то, имеют ли адреса в пределах нашего сайта в конце "/" или лишены этого. Размещение единого и стабильного дизайна сделает файл robots.txt более прозрачным.

- Даты в URL-адресах - делают синтаксис адресов неинтуитивным, и, если он размещен в больших количествах, управление файлом robots.txt может быть неэффективным и занимать много времени.

- Блокировка ценных ресурсов - неправильное введение директив блокировки в robots.txt может привести к блокировке ценных ресурсов веб-сайта для нас (это относится к определенным адресам, а также к изображениям и файлам CSS / JS). Перед использованием определенных правил рекомендуется использовать инструменты, которые проверяют работу синтаксиса, используемого в файле robots.txt.

- Большие буквы - проблема касается как именования файла, например, ROBOTS.txt, так и чередования прописных и строчных букв в адресах для блокировки директив. Следует помнить, что роботы поисковых систем обычно различают буквы.

- Субдомены. Распространенной ошибкой является отсутствие файла robots.txt в каталогах субдоменов. Помните, что субдомены должны рассматриваться как отдельные сервисы.

- Прозрачность файла. Неправильно применять директивы Allow / Disallow в одной строке. Googlebot игнорирует пустые символы, однако файл robots.txt становится менее прозрачным.

- Block robots - robots.txt не является эффективной защитой даже от спам-ботов, которые чаще всего игнорируют его содержимое. Из-за количества спам-роботов рекомендуется использовать другие формы блокировки контента, например, директиву в файле .htaccesss. Следует также принять во внимание, что более эффективный и быстрый способ индексации определенных ресурсов - это использование соответствующего мета-тега, который мы поместили в раздел <head> в исходном коде:

<meta name = "robots" content = "noindex">

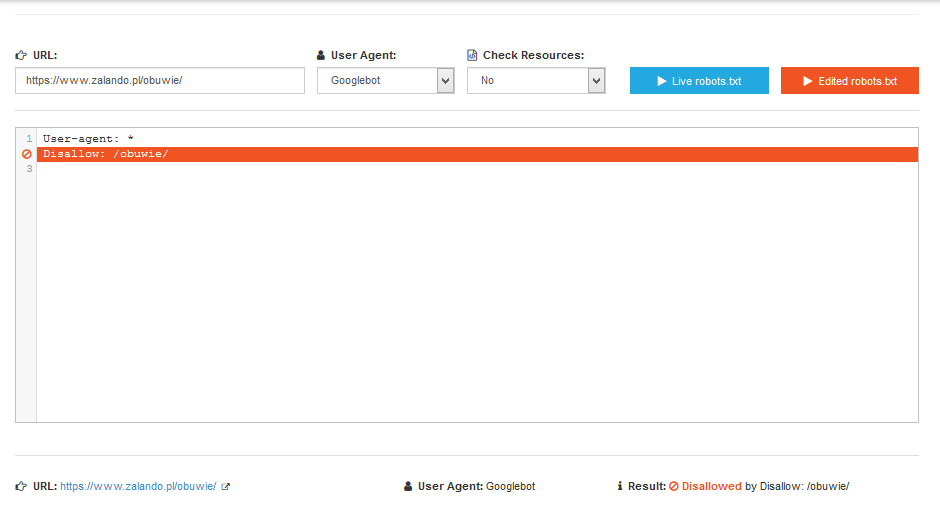

Примеры инструментов для тестирования содержимого файла robots.txt.

Технический тестер

https://technicalseo.com/seo-tools/robots-txt/ - инструмент проверяет действие директивы для любого выбранного адреса, он позволяет вам тестировать директивы перед их введением.

Robots.txt Тестер в консоли поиска Google

https://www.google.com/webmasters/tools/robots-testing-tool - тестер введенных директив для сайта, проверенный в Google Webmaster Tools.

суммирование

Следует помнить, что для создания конкретных директив, блокирующих ресурсы сайта , необходим доступ к основному каталогу сайта .

При реализации соответствующих директив обращайте особое внимание на их содержание, поскольку с помощью простого контроля или ошибок мы можем блокировать доступ роботов к важным для нас страницам .